Nvidia GB200 NVL72 поки не готова для навчання передових моделей ШІ

15:30, 26.08.2025

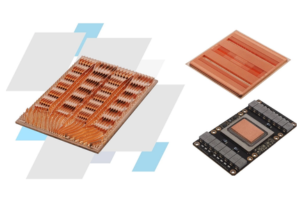

Аналітичне агентство SemiAnalysis опублікувало аналіз серверних рішень для навчання штучного інтелекту і дійшло висновку, що для навчання передових моделей на даний момент краще підходять прискорювачі Nvidia H100 і H200, а також TPU від Google. Серверні стійки GB200 NVL72 з новітніми GPU Nvidia стикаються з проблемами через мідну комутаційну плату NVLink і недосконалі засоби діагностики та налагодження, що призводить до простоїв.

Чому навчання поки що неможливе

Теоретично «відвал» одного чіпа не є критичним — в NVL72 рекомендується навчати ШІ на 64 GPU GB200, а ще 8 залишати в резерві. Однак для їх підключення необхідно швидко локалізувати несправність, що поки що є складним через обмежені діагностичні інструменти. В результаті зупиняється процес навчання, відкочуються чекпоінти і затягується ремонт. SemiAnalysis відзначає, що поки не відомий жоден завершений приклад тренування передової моделі на GB200 NVL72.

Рекомендації аналітиків і фокус Nvidia

На даний момент аналітики радять використовувати GB200 NVL72 переважно для інференсу — запуску вже навчених моделей. Nvidia в останніх матеріалах також робить акцент на інференсі, хоча в ранніх анонсах передбачалася паралельна робота над тренуванням і запуском моделей.

Прогноз на майбутнє та економічна сторона

SemiAnalysis прогнозує, що Nvidia зможе усунути проблеми з NVLink і програмним забезпеченням до кінця року. При цьому вартість володіння одним GPU GB200 в 1,6–1,7 рази вища, ніж у H100. Щоб виправдати інвестиції в нові прискорювачі, вони повинні демонструвати мінімум в 1,6 рази більшу продуктивність при аналогічному часі простою.